2 Open Science

“Political science is a community enterprise; the community of empirical political scientists needs access to the body of data necessary to replicate existing studies to understand, evaluate, and especially build on this work.” (King 1995, p. 444)

- universalism

- common ownership of goods

- Uneigennützigkeit

- organized skepticism

- Replikationskrisen

- open acces, open data

- common culture of data stewardship

- Forschungsdatenrepositorium

- DMP

- FAIR

- reproducibility

- replicability

2.1 Überblick

Unter Open Science (OS) versteht man den Ansatz, “of making the content and process of producing evidence and claims transparent and accessible to others” (Munafò u. a. 2017). Dieser Ansatz hat sich in den letzten Jahrzehnten zu einem der bestimmenden Themen in allen Wissenschaftsdiziplinen entwickelt. Die Ursachen dafür liegen in drei eng miteinander verbundenen Faktoren. Erstens einem generellen Verständnis von Wissenschaft als einer Institution organisierter Kritik. Zweitens den neuen, rasant wachsenden und sich verändernden Möglichkeiten und Herausforderungen der Technik. Und drittens, den in allen (zumindest empirisch ausgerichteten) Disziplinen gemachten Beobachtungen, dass wissenschaftliche Erkenntnisse in Studien nicht immer oder nur eingeschränkt bestätigt und wiederholt werden können.

Ziel dieses Kapitels ist es, zunächst auf diese drei Ursachen genauer einzugehen, bevor ich darlege, worin der Vorteil des Prinzips von Open Science liegt, welche Forderung die Open Science Community an die Wissenschaft stellt und welche Konsequenzen das für die Sozialwissenschaften und vor allem die Politikwissenschaft hat.

2.2 Die Ursachen der Open Science Bewegung

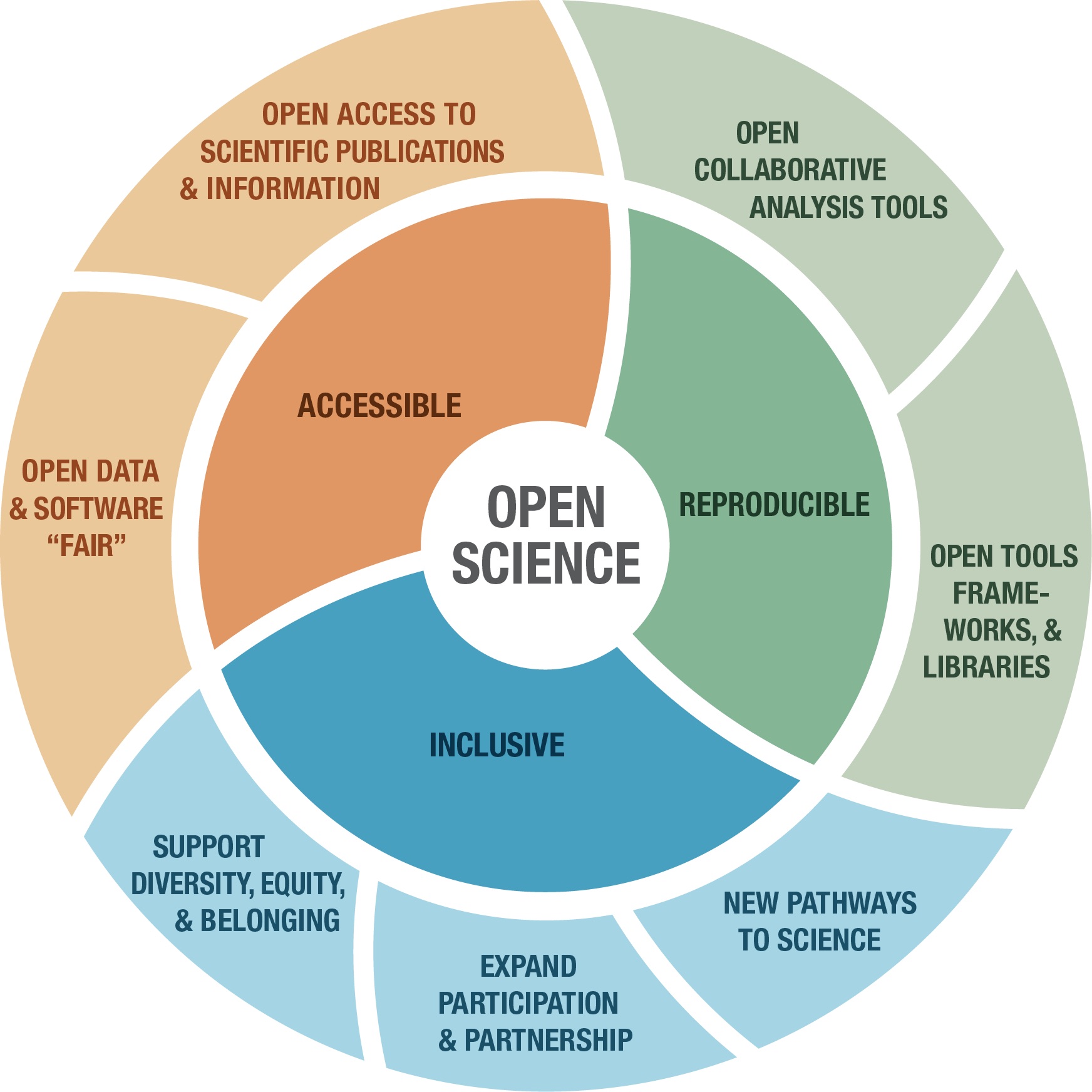

Ramachandran, Bugbee, und Murphy (2021) definieren Open Science als “collaborative culture enabled by technology that empowers the open sharing of data, information, and knowledge within the scientific community and the wider public to accelerate scientific research and understanding.” Wie Abbildung 2.1 zeigt, wird diese kollaborative Kultur von drei Facetten geprägt: (1) der Forderung, dass die Ergebnisse von Forschung in Form von Publikationen (open access) oder Daten, Materialien und Code (open data) frei zugänglich gemacht werden sollen (Crüwell u. a. 2019, pp. 239-241); (2) dem Anspruch, dass Forschungsergebnisse überprüfbar und nachvollziehbar gemacht werden müssen (Crüwell u. a. 2019, pp. 241-242); und (3) der Grundhaltung, dass Wissenschaft inklusiv und grundsätzlich allen Menschen zugänglich sein soll.

Drei Faktoren bzw. Entwicklungen sind verantwortlich für den Umstand, dass Open Science mittlerweile so an Bedeutung gewonnen hat: (1) die Wesensmerkmale von Wissenschaft, (2) die Möglichkeiten und Herausforderungen der Technik sowie (3) die Beobachtung, dass viele wissenschaftliche Erkenntnisse einer genauen Überprüfung nur bedingt standhalten.

Robert K. Merton, ein US-amerikanischer Wissenschaftssoziologe, argumentierte, dass die Wissenschaft durch vier Wesensmerkmale gekennzeichnet sei. Das erste Wesensmerkmal nach Merton (1973, p. 270) ist der Universalismus von Wissenschaft. Der Gehalt wissenschaftlicher Behauptungen, so seine Überzeugung, hänge nicht von dem Prestige der Person ab, die diese äußert. Ausschlaggebend sei vielmehr der Umstand, inwiefern diese Behauptungen hinterfragt wurden und der Kritik im Lauf der Zeit standhalten (Schlitz 2018b, p.1).

Das zweite Wesensmerkmal von Wissenschaft ist die “common ownership of goods” (Merton 1973, p. 273). Substantielle wissenschaftliche Erkenntnisse sind selten bis nie das Ergebnis von Einzelnen, sondern immer das Produkt der Zusammenarbeit von mehreren. King (1995, p. 444) spricht daher auch zu Recht davon, dass die Politikwissenschaft ein “community enterprise” sei. Wissenschaftliche Erkenntnisse gehören damit auch nicht Einzelnen oder gewissen Institutionen (wie Universitäten oder Forschungseinrichtungen), sondern der Allgemeinheit (Edwards 2016, p. S70). Sie sind somit ein öffentliches Gut.

Drittens war Merton (1973, p. 275-276) überzeugt, dass sich Wissenschaft durch Selbstlosigkeit bzw. Uneigennützigkeit (“disinterestedness”) auszeichne. Es geht in der Wissenschaft nicht um die Beförderung des eigenen Egos von Wissenschafter:innen, sondern um die Leidenschaft, Wissen zu generieren, neugierig zu sein und der Menschheit mit dem eigenen Handeln nützlich zu sein.

Schlussendlich bezeichnete Merton (1973, p. 274) die Wissenschaft als ein System der “organized criticism”. Wissenschaft müsse als ein normatives System verstanden werden, das die Kritik einfordert und überhaupt erst ermöglicht (Schlitz 2018b, p. 1; Janz und Freese 2021, p. 305). Nur durch die Selbstverpflichtung von Wissenschaft zur vollkommenen Transparenz (Dafoe 2014, p. 60), ist das Prinzip des Universalismus überhaupt aufrechterhaltbar und können Ergebnisse hinterfragt und kritisiert werden. Wissenschaft zeichnet sich daher vor allem durch eine “self-correcting ability” (Wuttke 2019, p. 2) aus.

Open Science wird aber nicht nur durch diese vier Wesensmerkmale von Wissenschaft befördert. Es sind auch die technischen Entwicklungen der letzten Jahrzehnte, die neue Möglichkeiten aber auch Herausforderungen für den Wissenschaftsbetrieb bringen. Dazu gehört zunächst die Erfindung und globale Verbreitung des Internets als einem Medium, das die Zusammenarbeit von Wissenschafter:innen bei der Erforschung komplexer Phänomene über Grenzen hinweg ermöglicht und vereinfacht (Bullinger 2003, p.1).

Es ist daneben aber besonders der technische Fortschritt in der rasant steigenden Rechenleistung von Computern bei gleichzeitig sinkenden Kosten, der zu einem Wandel in allen Wissenschaftsdisziplinen und zu neuen Fragestellungen geführt hat (Lazer 2009; Grimmer 2015; Liu und Guo 2016; Salganik 2018, p.3; Qui, May Chan, und Chan 2018). Begleitet wird dieser Wandel durch das Aufkommen neuer (digitaler) Daten, die noch dazu in bisher kaum vorstellbarer Größe vorhanden und zugänglich sind – so genannter “big data” (Jagadish 2015). Eine Entwicklung, die manche Beobachter:innen schon von einer “crisis of largness” (English und Underwood 2016, p. 279) sprechen lässt, also von einer Situation, in der die Menge an Daten nicht mehr wirklich bewältigbar ist.

Diese neuen Möglichkeiten an Rechenleistung, verbunden mit dem Umstand neuer und großer Datenquellen, führt zur wachsenden Bedeutung von “computational methods” der Datengewinnung und -auswertung, die immer komplexer werden und zwangsläufig nur mehr im Verbund und in Zusammenarbeit von Wissenschafter:innen angewendet werden können (Van Atteveldt, Althaus, und Wessler 2021, p. 291; Purcell 2019; Lazer 2009, p. 722; Bourne, Lorsch, und Green 2015, p. S16; English und Underwood 2016; Jagadish 2015).

Dieser “computational turn” der Wissenschaft hat mittlerweile auch die Sozial- (Lazer 2009) sowie die Geistes- und Kulturwissenschaften (Berry 2011) erreicht und zu einem Wandel des Forschens in diesen Bereichen geführt. Ähnlich den medizinischen, naturwissenschaftlichen und technischen Disziplinen erfordern die zunehmend komplexen Fragestellungen und Thematiken ein kollaboratives Arbeiten in Forschungsteams (Holmes 2016; Neupane 2016; Korku Avenyo 2016; Wagner, Whetsell, und Leydesdorff 2017).

Das heißt also, dass die Forderung Mertons, wonach Wissenschaft als Gemeinschaftsunternehmen zu verstehen sei, das auf der permanenten Selbstkritik fußt, durch die technischen Entwicklungen einerseits erst ermöglicht wird. Andererseits ist die Zusammenarbeit von Forscher:innen aber erforderlich, weil die Komplexität an Fragestellungen und neuen Methoden von Einzelnen nicht mehr bewältigt werden kann.

Das zeigt sich schlussendlich auch in der dritten Entwicklung, die ethische Aspekte in die Debatte einbrachte und Open Science zum Durchbruch verhalf. Dazu gehört zunächst die Kritik an dem Geschäftsmodell, das das wissenschaftliche Publizieren derzeit beherrscht. Die Forschung an den Universitäten und Forschungseinrichtungen wird vielerorts überwiegend mit öffentlichen Mitteln finanziert. Wissenschafter:innen übermitteln die Ergebnisse ihrer Forschung in Form von Publikationen (Artikel oder Bücher) unentgeldlich an Journals und Verlage. Wissenschafter:innen bringen sich darüber hinaus auch noch in die Begutachtung im Zuge des peer-review Verfahrens ein, ohne dafür entlohnt zu werden.

Journals und Verlage veröffentlichen diese Beiträge und verkaufen das finale “Produkt” (entweder in gedruckter Form oder zunehmend mehr über digitale Lizenzen) wiederum an die Universitäten und Forschungseinrichtungen, die dafür hohe Geldsummen investieren müssen. Der akademische Publikationsmarkt ist somit ein Milliarden Euro schweres Geschäftsmodell mit großen Gewinnen für die betreffenden Verlage (Van Noorden 2013).

Dieses Modell ist aus ethischer Sicht nicht vertretbar, weil es die Prinzipen des Universalimus bzw. der “common ownership of goods” verletzt. Nur ein kleiner und privilegierter Teil der Menschheit hat damit ungehindert Zugang zu wissenschaftlichen Erkenntnissen. Darüber hinaus kommt es zur Privatisierung öffentlicher Güter mit finanzieller Unterstützung durch öffentliche Mittel. Es ist schlicht und einfach nicht vertretbar, dass die Allgemeinheit Unsummen von Geld in Forschung steckt, deren Ergebnisse dann aber Verlagen geschenkt werden, um sie anschließend mit teurem Geld wieder zurückzukaufen.

Neben der Kritik an diesem Geschäftsmodell war es aber vor allem die Beobachtung über alle Wissenschaftsdisziplinen hinweg, dass viele wissenschaftliche Erkenntnisse oft einer genauen Überprüfung nicht standhielten oder erst gar nicht überprüfbar waren, und damit die betreffenden Disziplinen in eine Legitimationskrise brachten. Diese sogenannten “Replikationskrisen” betrafen nahezu alle Disziplinen, von den Natur- und Lebenswissenschaften (Ioannidis 2005; Prinz, Schlange, und Asadullah 2011), über die Psychologie (Open Science Collaboration 2015; Anderson und Maxwell 2017; Lilienfeld 2017) und Wirtschaftswissenschaften (Camerer u. a. 2016) bis hin zu den Sozialwissenschaften (Camerer u. a. 2018). Auch in der Politikwissenschaft (Graham u. a. 2023; Janz und Freese 2021, p. 305) wurde diese Problematik offenkundig und zwar sowohl bei quantitativ ausgerichteten Studien als auch bei jenen, die auf ein qualitatives Forschungsdesign setzen (Rohlfing u. a. 2021; Kapiszewski und Karcher 2021, p. 285).

Die Ursachen für diese Replikationskrisen sind vielfältig und reichen von “noisy research settings” (Loken und Gelman 2017, p. 584) – also unklar definierten Rahmenbedingungen des Forschungsdesigns – über zu kleine Stichproben (Maxwell, Lau, und Howard 2018), bis hin zu selektiven Analysen und Übermittlung von Ergebnissen (Open Science Collaboration 2015, 943).

Sehr anschaulich wird diese Problematik am Beispiel einer Studie von Breznau u. a. (2022). Dabei wurden 161 Forscher:innen in 73 Forschungsteams gebeten, unabhängig von einander die Frage zu untersuchen, welchen Zusammenhang es zwischen Immigration einerseits und der öffentlichen Meinung zu staatlichen Sozialprogrammen andererseits gibt. Alle Forscher:innen arbeiteten dabei mit den gleichen “cross-country survey data”. Die Ergebnisse reichten von “large negative effects” (Immigration reduziert die positive Einstellung der Bevölkerung zu staatlichen Sozialprogrammen) bis hin zu “large positive effects” (Breznau u. a. 2022, p. 1). Das heißt, trotz derselben Datengrundlage variierten die Ergebnisse der Forschungsteams beträchtlich.

Um diesem Problem zu begegnen, wird daher gefordert, mehr “Metascience” (Maxwell, Lau, und Howard 2018; Schooler 2014) zu betreiben, also zu erforschen, wie Wissenschaft überhaupt betrieben wird.1 Daneben wird auch der Ruf nach der “pre-registration” (Shrout und Rodgers 2018) von Forschungsvorhaben immer lauter. Damit ist die Anmeldung von Forschungsprojekten und der Übermittlung von Forschungsdesigns gemeint, bevor diese tatsächlich umgesetzt werden, um die nachträgliche Manipulation von Datenerhebung und -auswertung bzw. die Übermittlung selektiver Ergebnisse zu erschweren.

1 Die Universität Innsbruck ist in diesem Bereich mit den Kollegen Michael Kirchler, Felix Holzmeister ( flxhlzmstr) und Jürgen Huber international führend und hat dazu wichtige Studien in den Bereichen Sozial- und Wirtschaftswissenschaften beigetragen. Siehe dazu den Newsroom Beitrag Meta science: Die Wissenschaft über Wissenschaft.

Somit wird letztendlich gefordert, dass man sich wieder stärker auf Mertons Wesensmerkmale von Wissenschaft konzentriert und ihnen folgt. Es braucht eine neue Forschungskultur, in der “ehrliche Fehler” (also solche, die nicht aus bösen Täuschungsabsichten resultieren) als selbstverständlich angesehen werden, wo unterschiedliche Forschungsergebnisse als natürliche Folge unterschiedlicher Forschungsprozesse verstanden werden, und wo ein hohes Maß an Transparenz vorherrscht, um Schwächen oder Fehler von Forschungsergebnissen kollaborativ erkennen und deren zugrundeliegende Prozesse besser verstehen zu können (Janz und Freese 2021, p. 305).

Genau deshalb braucht es Open Science. OS hilft das merton’sche Verständnis von Wissenschaft vor dem Hintergrund immer komplexerer Fragestellungen und Thematiken aktiv zu leben und damit der wachsenden “crisis of credibility” (Janz und Freese 2021, p. 305), aufgedeckt unter anderem durch die Replikationskrisen, zu begegnen.

2.3 Forderungen und Grundlagen von Open Science

Vor diesem Hintergrund fordert die Open Science Bewegung, alle Phasen eines Forschungsprozesses transparent und nachvollziehbar zu gestalten. Alle Ergebnisse von Forschung, sowie die ihr zugrundeliegenden Daten und Methoden, sollen offen und frei verfügbar gemacht werden. Dadurch erhofft man sich mehrere Vorteile, die die weiter oben erwähnten Wesensmerkmale von Wissenschaft, aber auch die Probleme und Herausforderungen von Forschung adressieren sollen.

Als ersten Vorteil von Open Science wird die Stärkung des Prinzips der Universalität genannt (Schlitz 2018a, p. i). Damit wird der Zugang zu Forschungsergebnissen für arm und reich wieder möglich (BOAI 2002) und ein Gegenmodell zur Monetarisierung von Forschungsergebnissen präsentiert (Schlitz 2018a, p. i). Open Science sorgt damit für ein Mehr an Inklusion (Rinke und Wuttke 2021, pp. 281-282). Mehr Menschen können an den Ergebnisse von Wissenschaft teilhaben bzw. sich an deren Erbringung beteiligen.

Zweitens ermöglicht Open Science die gemeinsame Suche nach Wissen (BOAI 2002; Engzell und Rohrer 2021, p. 299; Rinke und Wuttke 2021, p. 281), reduziert die Wahrscheinlichkeit unnötiger Verdoppelung von Forschungsarbeit (Engzell und Rohrer 2021, p. 299) und beschleunigt somit die Wissensgewinnung (BOAI 2002; Edwards 2016, p. S70).

Forschungsergebnisse kommen mit Hilfe von Open Science aber nicht nur schneller ans Licht der Welt, sondern auch deren Qualität steigt (Engzell und Rohrer 2021, p. 300; Lupia 2021, p. 301). Vor allem auch deshalb, weil die Selbstkontrolle und die Möglichkeiten der Überprüfung von Resultaten durch OS verbessert werden (Engzell und Rohrer 2021, p. 299).

Damit sorgt Open Science schlussendlich einerseits für ein höheres Maß an Transparenz in der Wissenschaft (Rinke und Wuttke 2021, p. 281) und steigert andererseits auch deren Legitimation (Lupia 2021, p. 302), und zwar sowohl nach “innen” (also gegenüber der Wissenschaftsgemeinschaft) als auch nach “außen” in Richtung Gesellschaft.

Um diesen Mehrwert von Open Science auch wirklich generieren zu können, wird ein Bündel von Forderungen gestellt, die im Zuge des Wandels hin zu OS umgesetzt werden sollen. Die erste und grundlegendste dieser Forderungen ist der Anspruch, dass Forschungsergebnisse von Grund auf offen und frei verfügbar sein sollen, das heißt also “open access by default” (EOSC 2017, p. 1). Der freie Zugang zu Forschungsergebnissen muss somit nicht erst argumentiert werden, sondern es kommt zu einer Umkehr der Logik. Es müssen nämlich gute und trifftige Gründe (zB die nationale Sicherheit) angeführt werden, um Forschungsergebnisse nicht öffentlich machen zu müssen.

Dazu braucht es zweitens die Gründung neuer und den Wandel bereits bestehender Zeitschriften zu Open Access Journals (BOAI 2002). Nur wenn Wissenschafter:innen Qualitätsjournals zur Veröffentlichung zur Verfügung haben, die nach dem Prinzip von Open Science organisiert sind, kann die Transformation gelingen. Diesen Schritt hat die Österreichische Gesellschaft für Politikwissenschaft (ÖGPW) bereits vor einigen Jahren unternommen und ihre im Web-of-Science indizierte Zeitschrift – die Österreichische Zeitschrift für Politikwissenschaft (ÖZP) – mit Hilfe einer Förderung des Wissenschaftsfonds FWF zur Open Access Zeitschrift gemacht. Weder Autor:innen noch Leser:innen müssen für die Veröffentlichung oder die Nutzung der Beiträge zahlen, sondern können frei und ungehindert auf Forschungsergebnisse zugreifen.

Drittens wird die Etablierung einer “common culture of data-stewardship” gefordert. Jede Phase eines Forschungsprozesses und jede Art von Output von Forschung (auch Zwischenergebnisse und Methoden bzw. Code) sollen transparent, frei und öffentlich zugänglich gemacht werden. Es geht als nicht nur um Bücher oder Artikel, sondern auch um die zugrundeliegenden Daten; die Wege und Tools der Datenerhebung und -auswertung; die Software und den Code, der dafür benutzt wurde; sowie Leitfäden und Kodierschema, die für den Forschungsprozess essentiell waren (EOSC 2017, p. 1; Wilkinson u. a. 2016, p. 1; Stratmann 2003, p. 2; The Declaration on Research Assessment 2012). Dieses Denken muss in die Köpfe der Wissenschafter:innen, die Forschungsprozesse von Beginn an nach diesen Anforderungen gestalten sollten.

Um diesen Kulturwandel zu schaffen, braucht es viertens Anreizsysteme im Wissenschaftsbetrieb, Schulungen von Wissenschafter:innen und die Aufnahme von Open Science in die Ausbildung von Studierenden sowie den Aufbau von Forschungsinfrastruktur, die den Anforderungen von Open Science gerecht wird. Um Anreizsysteme für Open Science im Wissenschaftsbetrieb zu schaffen, muss die Forschungsförderung schrittweise Fördernehmer:innen dazu verpflichten, die Ergebnisse ihrer geförderten Projekte nach den Prinzipien von Open Science frei zur Verfügung zu stellen. Mit Hilfe des Plan S (cOAlitionS 2018) ist das innerhalb Europas schon auf den Weg gebracht worden. Aber auch auf Ebene von Universitäten und ihren Organisationseinheiten müssen Anreizsysteme geschaffen werden. Bei der Evaluation von Fakultäten, Instituten oder Arbeitsbereichen sowie bei der Evaluation individueller Forscher:innen muss Open Science zunehmend eine Rolle spielen (EOSC 2017, p. 1; Stall 2019, p. 29).

Neben diesen Anreizsystemen braucht es die Aufnahme von Open Science in die Weiterbildungsprogramme auf universitärer Ebene, bzw. die Einbeziehung von Open Science als Grundprinzip in die Curricula von Studienprogrammen. Open Science muss zum selbstverständlichen Teil der (Aus)Bildung einer neuen Generation von Studierenden werden (EOSC 2017, p. i). Dabei gilt es aber darauf zu achten, dass diese Inhalte nicht als ein mögliches “Zusatzthema” vermittelt, sondern als grundlegende Elemente von Wissenschaft wahrgenommen werden, die Forschungsprozesse strukturieren.

Schlussendlich braucht es für die Transformation die notwendige Forschungsinfrastruktur, um Open Science überhaupt betreiben zu können. Allen voran braucht es Forschungsdatenrepositorien und das Wissen um die Erstellung und Nutzung von Data Management Plans, sogenannten DMPs (EOSC 2017, p. 1). Mit Forschungsdatenrepositorien sind Systeme gemeint, die das langfristige, sichere und nachvollziehbare Speichern und Nutzen von Forschungsdaten im weiteren Sinne (also nicht nur Daten, sondern auch Code, Dokumentationen, etc.) ermöglichen.

Während solche Repositorien in den Naturwissenschaften schon weit verbreitet sind (zB Zenodo welches von CERN, der europäischen Organisation für Kernforschung, betrieben wird), sind diese Systeme in den Geistes- und Kulturwissenschaften oder den Sozialwissenschaften2 erst im Aufbau. In Österreich gibt es aber mittlerweile mit ARCHE und GAMS bereits solche Systeme für die Geistes- und Kulturwissenschaften. Mit AUSSDA - The Austrian Social Science Data Archive haben auch die Sozialwissenschaften ein sehr erfolgreiches und international zertifiziertes Repositorium, das in dem europäischen Verbund CESSDA integriert und damit mit anderen nationalstaatlichen Forschungsdatenrepositorien im Bereich der Sozialwissenschaften verbunden ist.

2 In den Sozialwissenschaften wird oft auf das Harvard Dataverse zurückgegriffen, das es Forscher:innen erlaubt, ihre Forschungsdaten im weiteren Sinne zu archivieren und anderen zur Verfügung zu stellen. Der Nachteil von Harvard Dataverse (zumindest aus europäischer Sicht) ist jedoch, dass die Daten auf US-Servern liegen und damit nicht den strengen europäischen Datenschutzgesetzen unterliegen.

Neben dieser Forschungsdateninfrastruktur braucht es noch das Wissen um die Erstellung und Nutzung von DMPs. Daten Management Pläne sind Anleitungen, die am Beginn des Forschungsprozesses gemacht werden. Sie versuchen darzulegen, wie man Daten im Zuge der eigenen Forschung erheben und auswerten will (Michener 2015); wie man diese Daten und den Prozess der Erhebung und Auswertung langfristig transparent, nachvollziehbar, frei und öffentlich zugänglich gestalten will; und wie man gedenkt, mit den Herausforderungen von Daten generell (zB zum Schutz der Persönlichkeitsrechte oder wenn Urheber:innen- und Nutzungsrechte vorliegen, siehe dazu vor allem Van Atteveldt, Althaus, und Wessler (2021, p. 192)) umzugehen (Michener 2015).

Um Forschungsdatenrepositorien und DMPs aber effizient und nachvollziehbar nutzen zu können, haben sich die von Wilkinson u. a. (2016) vorgeschlagenen FAIR-Prinzipien (siehe Tabelle 2.1) etabliert. Sie regeln, nach welchen Prinzipien Forschungsdaten abgespeichert werden sollen und worauf man dabei achten muss.

| FAIR-Prinzipien | Forschungsdaten sollten so abgespeichert werden, dass sie |

|---|---|

| Findable | (auffindbar) sind, indem sie unter anderem mit DOIs3 versehen und mit umfangreichen Metadaten kommentiert werden. |

| Accessible | (zugänglich) sind, indem standardisierte, freie und offene Protokolle zur Anwendung kommen und die Metadaten auch dann noch zur Verfügung stehen, wenn es die Daten selber nicht mehr geben sollte. |

| Interoperable | (kompatibel) sind, indem eine allgemein gültige Sprache für deren Beschreibung verwendet wird und sie Querverweise zu anderen Daten enthalten. |

| Reusable | (wiederverwendbar) sind, indem die Daten ausreichend beschrieben und dokumentiert werden, damit sie jederzeit von anderen verwendet werden können. |

3 Unter DOI versteht man einen “Digital Object Identifier” also einen eindeutigen Link zu einem digitalen Objekt, der persisent und damit langfristig beständig ist. Siehe dazu www.doi.org.

Das übergeordnete Ziel muss laut Wilkinson u. a. (2016, p.3) daher sein, Forschungsdaten zu einem zentralen Bestandteil des Forschungsoutputs zu machen, der maßgeblich zur Qualität von Publikationen beiträgt:

The goal is for scholarly digital objects of all kinds to become ‘first class citizens’ in the scientific publication ecosystem, where the quality of the publication – and more importantly, the impact of the publication -— is a function of its ability to be accurately and appropriately found, reused, and cited over time, by all stakeholders, both human and mechanical.

Auf diese Art und Weise wird es nämlich möglich, Forschungsergebnisse überprüfbar und nachvollziehbar zu machen. Damit können die Wesensmerkmale von Wissenschaft nach Merton auch wirklich eingehalten werden. Unterschieden werden muss dabei aber zwischen zwei Konzepten, inwiefern Forschungsergebnisse überprüfbar und nachvollziehbar gemacht werden können – (1) reproducibility und (2) replicability.

Unter “reproducibility” versteht man den erfolgreichen Versuch, mit Hilfe derselben Daten und derselben Analyseschritte (also zB des gleichen Codes) zu denselben Ergebnissen wie die Ausgangsstudie zu kommen (Engzell und Rohrer 2021, p. 297; Alvarez und Heuberger 2022, p. 149; Rohlfing u. a. 2021, p. 292). King (1995, p. 451) nennt dieses Konzept daher auch “duplication”, weil es am Ende des Tages um die Wiederholung derselben Schritte im Forschungsprozess, mit Hilfe derselben Daten und Instrumente, wie in der ursprünglichen Studie geht.

Die Alternative dazu ist “replicability”, bei der die Analyseschritte einer Studie verwendet werden, um Daten neu zu generieren und auszuwerten (Engzell und Rohrer 2021, p. 297; Alvarez und Heuberger 2022, p. 149; King 1995, p.451). Hier geht es also darum, mit Hilfe des Wissens um die Datenerhebung und Auswertung eine Studie von Grund auf zu wiederholen und zu den gleichen Forschungsergebnissen zu kommen, wie King (1995, p. 444) es beschreibt:

“The replication standard holds that sufficient information exists with which to understand, evaluate, and build upon a prior work if a third party could replicate the results without any additional information by the author.”

Anderson und Maxwell (2017, p. 305) und Open Science Collaboration (2015, p. 943) argumentieren daher auch abgeleitet davon, dass der Wert von Forschung (dem Prinzip der Universalität folgend) nicht an den dahinter stehenden Personen und ihrem Ansehen festgemacht werden sollte, sondern am Umstand, inwiefern die Ergebnisse diesem Replikationsstandard entsprechen oder nicht.

Aus einem solchen Replikationsstandard leitet sich allerdings auch die Notwendigkeit ab, dass die Praktiken des Speicherns und Tauschens von Forschungsdaten langfristig harmonisiert werden (Stall 2019, p. 28) bzw. dass es allgemein (oder zumindest Disziplinen-spezifisch) verbindliche Richtlinien gibt, wie man mit Forschungsdaten im weiteren Sinne umgehen soll (Alvarez und Heuberger 2022, p. 149; Shrout und Rodgers 2018, p. 407). Colaresi (2016) schlägt in diesem Zusammenhang sogar vor, dass jedes Journal einen eigenen Standard entwickeln soll und Autor:innen vor der finalen Publikationen ihres Beitrages in der Zeitschrift dafür Sorge tragen müssen, dass ihre Forschungsdaten reibungslos repliziert werden können.

Wie solche Richtlinien ausschauen könnten, hat Dafoe (2014, p. 64) am Beispiel von Forschung mit Hilfe statistischer Datenanalyse versucht darzulegen (siehe Tabelle 2.2). Das Grundprinzip dieser sieben Schritte kann aber in leicht abgewandelter Form auch auf jede andere Art von empirischer Forschung angewandt werden.

| Schritt | Erläuterung |

|---|---|

| 1. Programmieren mittels Code | Die Datenerhebung, -bearbeitung und -auswertung sollte mittels Code erfolgen, um nachvollziehbar gemacht werden zu können. |

| 2. Sauberes Programmieren | Der Code sollte einfach gestaltet und klar kommentiert und dokumentiert werden. Vor der Finalisierung eines Papers sollte der Code noch einmal zur Gänze ausgeführt werden. |

| 3. Analyse auf Grundlage von Rohdaten | Die Analyse sollte stets schon bei den Rohdaten beginnen und dokumentiert werden und nicht erst ab dem Masterdatensatz. |

| 4. Variablen | Alle Variablen eines Datensatzes sollten mit eindeutigen und verständlichen Bezeichnungen versehen und dokumentiert werden. |

| 5. empirische Behauptungen | Jede empirische Behauptung in einem Paper muss dokumentiert und damit überprüfbar gemacht werden. |

| 6. Archivierung von Daten | Die finalen Daten im weitesten Sinne (also auch die Dokumentation und der zu den Daten gehörende Code) müssen sicher in einem Repositorium archiviert werden. |

| 7. Koautor:innen | Auch Koautor:innen sollten nach den gleichen Standards arbeiten und dazu animiert werden, diese Schritte kollaborativ umzusetzen. |

2.4 Zusammenfassung

Ziel dieses Kapitels war es, eine Einführung in Open Science als einer kollaborativen Kultur der Transparenz und Offenheit zu geben. Ich habe zunächst dargelegt, wie die Wesensmerkmale von Wissenschaft, der technologische Wandel und die Replikationskrisen der letzten Jahrzehnte OS notwendig gemacht haben. Darauf aufbauend habe ich gezeigt, welche Vorteile OS bietet und welche Forderungen umgesetzt werden müssen, damit es wirklich zu einem Wandel der Forschungspraxis hin zu OS kommen kann.

Ziel für Forscher:innen und Studierende muss es mittel- bis längerfristig daher sein, Forschungsprozesse von Beginn an nach den OS-Prinzipien zu denken und auszurichten. Alle Forschungsergebnisse (sowohl Publikationen, als auch Daten, Codes und etwaige weitere Materialien) sollten automatisch öffentlich und frei zugänglich gemacht werden. Aber nicht nur der Output von Forschung, auch die Prozesse, die zu diesem Output führen, müssen transparent und nachvollziehbar gemacht werden. Gute Forschung zeichnet sich nämlich dadurch aus, dass sie der Kritik über einen längeren Zeitraum standhalten kann. Um aber kritisiert werden zu können, müssen die Ergebnisse und Prozesse ungehindert überprüfbar und nachvollziehbar gemacht werden.

Weiterführende Informationen

Merton, Rober K. 1973. “The Normative Structure of Science.” In The Sociology of Science: Theoretical and Empirical Investigations, edited by Norman W. Storer, 267–78. Chicago und London: The University of Chicago Press.

Ramachandran, Rahul, Kaylin Bugbee, and Kevin Murphy. 2021. “From Open Data to Open Science.” Earth and Space Science 8 (5): e2020EA001562. https://doi.org/10.1029/2020EA001562.

Wilkinson, Mark D., Michel Dumontier, IJsbrand Jan Aalbersberg, Gabrielle Appleton, Myles Axton, Arie Baak, Niklas Blomberg, et al. 2016. “The FAIR Guiding Principles for Scientific Data Management and Stewardship.” Scientific Data 3 (160018): 1–9. https://doi.org/10.1038/sdata.2016.18.

(a) Universalismus,

(b) common ownershoip of goods,

(c) Uneigennützigkeit,

(d) organized skepticism.

Antwort (a): Nacht Merton ist das Prinzip des Universalismus eines der Wesensmerkmale von Wissenschaft. Der Wert wissenschaftlicher Erkenntnisse hängt demnach nicht vom Ansehen der Person ab, die sie äußert. Vielmehr ist der Wert am Umstand zu messen, inwiefern diese Erkenntnisse im Laufe der Zeit der Kritik standgehalten haben.

(a) Für die einfache Zugänglichkeit von Daten.

(b) Für das problemlose Zusammenspiel von Daten.

(c) Für das leichte Wiederauffinden von Daten.

(d) Für die unbegrenzte Wiederverwendbarkeit von Daten.

Antwort (c): Der Buchstabe ‘F’ steht für ‘Findable’. Forschungsdaten sollten demnach so abgespeichert werden, dass sie auffindbar sind, indem sie unter anderem mit DOIs versehen und mit umfangreichen Metadaten kommentiert werden.

(a) Überprüfen und Nachvollziehen von Forschungsergebnissen auf Grundlage bereits vorhandener Daten und des ursprünglichen Forschungsdesigns.

(b) Überprüfen und Nachvollziehen von Forschungsergebnissen durch die Generierung neuer Daten und deren anschließender Analyse auf Basis eines bereits bestehenden Forschungsdesigns.

(c) Überprüfen und Nachvollziehen von Forschungsergebnissen durch die Generierung neuer Daten und deren anschließender Analyse auf Basis eines neuen Forschungsdesigns.

(d) Überprüfen und Nachvollziehen von Forschungsergebnissen auf Grundlage bereits vorhandener Daten und eines neuen Forschungsdesigns.

Antwort (b): Im Gegensatz zu ‘reproducibility’ wird bei der ‘replicability’ von Studien das vorhandene Forschungsdesign der zu überprüfenden Studie genutzt, um neue Daten zu generieren und diese nach dem ursprünglichen Forschungsdesign zu analysieren. Eine Studie ist dann ‘reproducible’, wenn die Ergebnisse der ‘reproduction’ vergleichbar sind.